数字媒体艺术 计算机科学与技术 软考报名 信息处理技术员 行业资讯 考试大纲 直播动态 网络安全 网络管理 通信技术 OpenHarmony 计算机与网络 企业信息化 软件工程 Linux 嵌入式Linux开发基础(ARMAtom) 离散数学 操作系统 C++程序设计 Java 语言程序设计 智能感知与无人系统 机器学习算法与人工智能 Python 软考资讯

随着智能时代的到来,无人化、智能化逐渐成为工业界关注的重点。智能无人系统发展迅速,从陆地到海洋,从空中到空间,从物理系统到信息系统,各种智能无人系统大量出现,无人车、无人机、无人潜航器、无人船、各种机器人在物流、交通、工业、农业、教育、医疗保健等领域得到广泛应用[1]。智能无人系统已成为推动经济发展、社会进步、工业变革的新引擎[2]。随着AI技术的发展,智能无人系统面临的任务越发复杂,通常要求系统能够在未知环境中自主完成任务。为解决智能无人系统在未知环境及不确定性任务方面的决策问题,智能无人系统必须具备自主地综合各传感器提供的感知信息,并实时与环境进行交互的能力。但是传感器收集到的感知信息是不全面的,其中夹杂着各种噪声,同时智能无人系统的决策也具有不可预知性,这种不确定性为智能体的规划和感知带来很大挑战。

强化学习是解决智能无人系统序列化决策问题的途径之一,适用于复杂任务的智能决策、集群任务的自主决策、交互式任务的决策规划。目前的任务决策方法主要适用于解决确定性条件下的静态决策问题,而在实际应用时,由于智能无人系统的任务环境存在部分可观测性以及可能存在对抗行为,决策时所依赖的环境是不确定且动态变化的。综合考虑任务的不确定性与突发性,智能无人系统之间的竞争与协作关系,使智能无人系统能够以自我为单位,克服环境不确定性与动态性所带来的影响,做出整体效果最优的实时决策,是智能无人系统决策管理的目标。

本文结合智能无人系统的特点,在其决策管理过程中应用强化学习技术,考虑到智能无人系统经常用于执行探测任务,以探测决策为例进行具体描述,充分体现强化学习平台在提高探测决策的智能化程度中的作用。

随着人工智能、仿生、机器学习等颠覆性前沿科学技术的发展,催生了无人系统发展的革命性变革,即向智能无人系统发展,其关键技术为:环境感知技术、定位与导航技术、时统技术、控制算法[3]。智能无人系统的种类、功能趋于多样化、跨域化、组网化、协同化,不再强调追求单个智能无人系统功能的最大、最强化,而是通过系统集成手段,将单一系统的功能分布化,通过组网、集群形成分布式能力[4]。

智能无人系统的特点主要体现在6个方面:1)安全可靠的互连性与互操作性;2)高效的信息管理和分发;3)可靠实时的信息保障;4)安全快速的网络资源和服务;5)精确快速的信息融合;6)决策支持;7)协同控制。其中包含6大技术:数据传输技术、数据分发管理技术、决策支持技术、数据保障与安全技术、快速建模和仿真技术、协作处理技术。智能无人系统的特点还体现在物理环境适应能力强、风险小、代价低、非接触、无人伤亡、长续航、多功能、自主可控、可成组编队等方面[5]。智能无人系统通过信息优势形成决策优势,由于任务区域越来越广泛,任务类型不断拓展,智能无人系统需要在多种任务中开展灵活有效的协调,并决策出到达任务目标的路径。

智能无人系统虽然能进行路径规划、避障避碰等智能行为,但是由于环境态势以及规划的复杂多变,智能无人系统很难迅速采取有针对性的措施,做出正确决策[6]。智能无人系统需要在复杂环境下快速稳定地进行决策,并具备应对非预期状态的能力。为确保智能无人系统能够在复杂环境中自主协同地完成各项任务,必须解决环境自适应、自主对接与回收、协同控制、协同导航与定位等技术问题[7]。智能无人系统集动力、机动、控制、传感器、人工智能等多学科先进技术于一体,是机械化信息化智能化高度融合、军民技术高度融合的典型产品,具有很高的环境和任务适应性特点[8]。考虑到智能无人系统所处环境具有多样性与复杂性的特点,如何在传感器有限的情况下对环境和态势进行准确感知与决策,是亟待解决的关键问题之一。考虑到智能无人系统所处环境具有高动态性和不确定性的特点,智能体如何利用自学习和自适应能力快速完成决策,是亟待解决的关键问题之二。

强化学习任务通常用马尔可夫决策过程来描述[9]。强化学习的基本思想是通过最大化智能体从环境中获得的累计奖赏值,以学习到完成目标的最优策略,因此强化学习方法更加侧重于学习解决问题的策略[10]。强化学习的特点有:无监督学习,奖赏的反馈有延迟,智能体选择的动作会影响之后接收的数据等[11]。强化学习必须在利用和探索之间进行折中,即在已知的信息下进行最优策略选择和新路径探索之间的折中[12],使智能无人系统能够与其所处的环境进行交互,根据环境反馈学习最佳行为,并通过反复实验不断改进决策。总之,强化学习赋予了智能体自监督学习能力,使智能无人系统能够自主地与环境交互,在试错中不断进步[13]。

智能无人系统往往由于环境及任务复杂度高而难以实施决策管理,利用强化学习平台进行智能无人系统决策管理是很好的解决方案。强化学习是机器学习领域的重要分支,也是人工智能领域的一个研究热点。强化学习是一种特殊的机器学习,通过与环境的自主交互过程来学习决策策略,使得策略的长期累积奖励值最大[14],通过强化学习平台和仿真平台的对接来进行决策模型搭建和智能体训练,并通过对智能体输出策略的控制来实现智能无人系统的决策管理。强化学习在智能无人系统决策管理中的应用可细分为:分层强化学习、分形强化学习、多智能体强化学习、多任务迁移强化学习、信息融合的强化学习、基于推理的强化学习等。

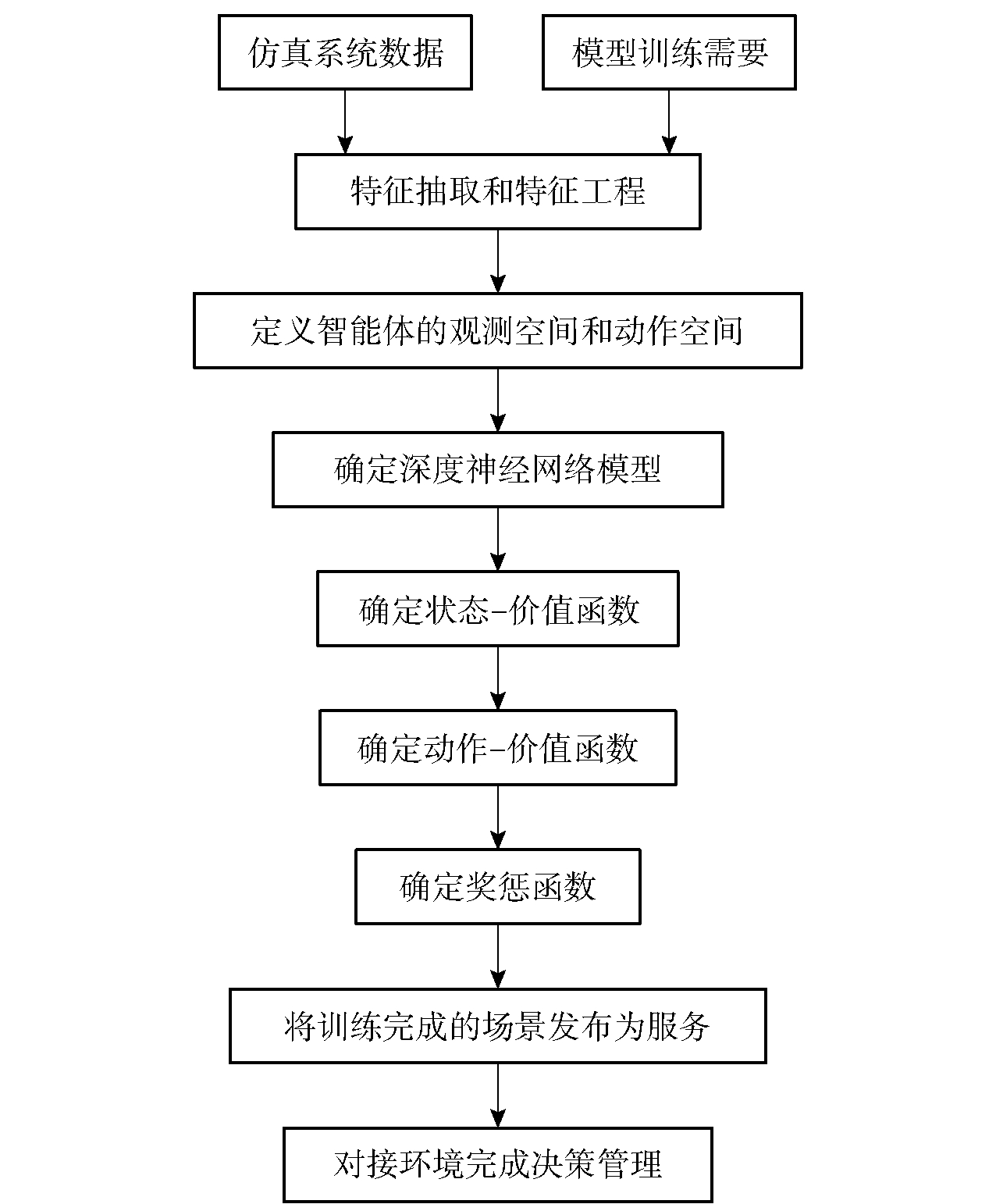

根据仿真系统中的数据和模型训练效果的需要,进行特征抽取和特征工程,定义强化学习智能体的观测空间和动作空间,如果强化学习的环境是完全可观测的,则观测空间实际上就是智能体的状态空间;如果智能体不能完整并准确地观测到自身所处状态,则决策管理问题从完全可观测问题转化为部分可观测问题。此时,需要考虑观测函数,用于决定智能体所处状态的观测情况。将智能体用以决定如何采取动作的机制表示为由参数确定的深度神经网络模型,智能体按照策略与环境交互过程中产生状态- 动作序列,将智能体获得的累积奖励表示为状态- 价值函数,将执行动作之后智能体获得的累积奖励表示为动作- 价值函数。通过智能体与环境交互产生数据,根据这些数据学习智能体的策略,设计相应的奖惩函数,让训练完成的智能体按照已经学习的策略与环境交互。具体过程见图1。

图1 应用强化学习的决策管理过程

Fig.1 The decision management process of applying

reinforcement learning

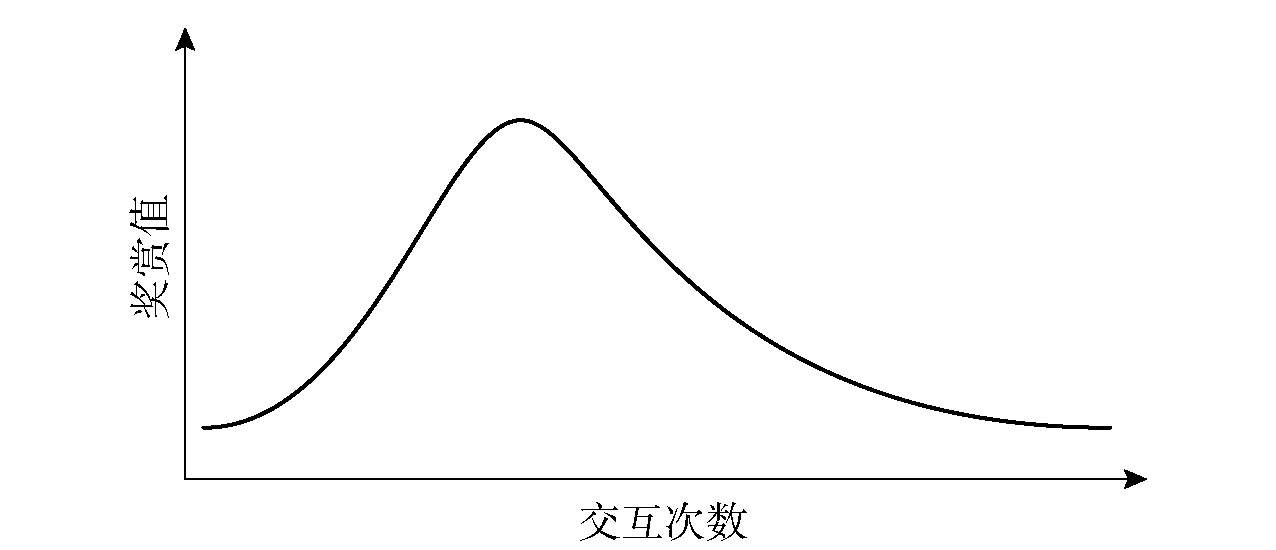

将智能无人系统的决策管理问题封装成一个环境类,环境类是要解决的问题与强化学习平台之间的接口,其基类为单智能体环境和多智能体环境。强化学习平台通过环境类获取决策管理问题的相关信息,控制决策管理问题中的智能体与环境进行交互,并产生反馈。将决策管理问题封装成一个环境基类的派生类后,强化学习平台获得所有智能体在当前时间点意图执行的动作,并令环境处理这些动作,产生交互,将智能体所处的新状态表示为转移函数,将智能体获得的奖励表示为奖励函数。然后定义环境中智能体的观测空间状态(例如离散型空间、连续型空间、混合型空间)和动作空间状态。一个环境可以使用不同的配置创建多个场景,每个场景都有最优算法以及算法对应的最优奖赏值,通过最优算法曲线(见图2)展示,并展示不同超参组合下的效果变化。

图2 最优算法曲线

Fig.2 Optimal algorithm curve

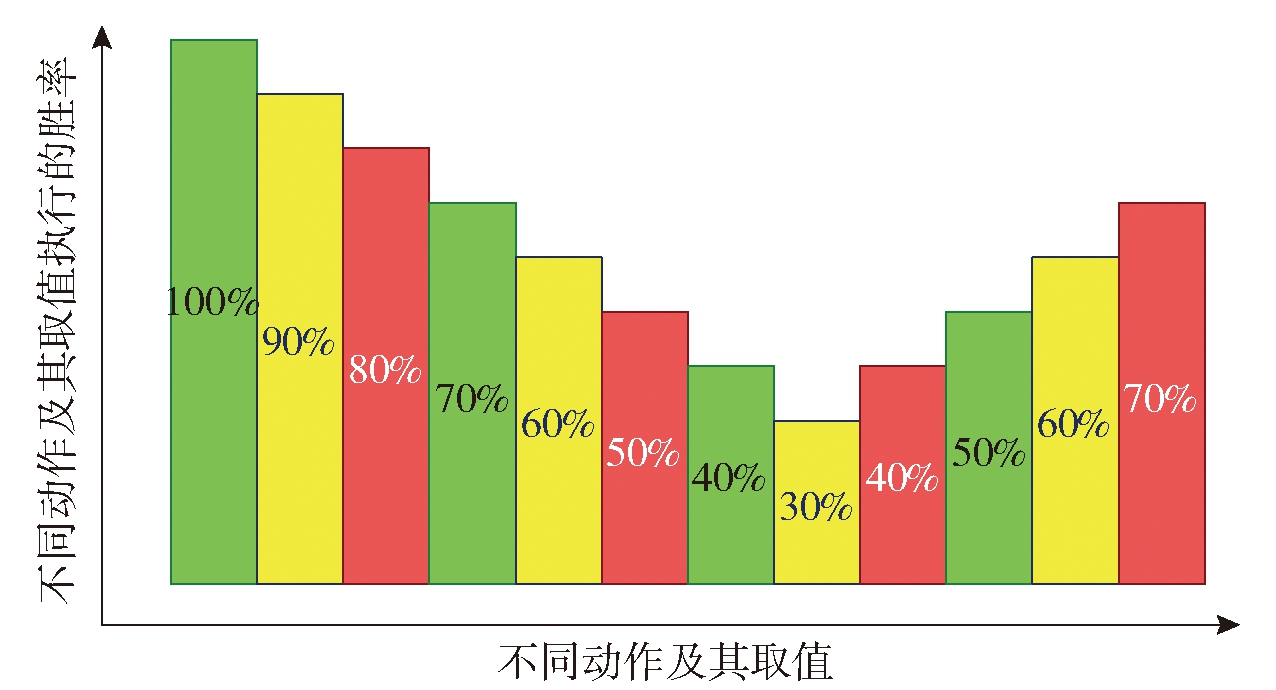

图3 决策管理柱状图

Fig.3 Decision management histogram

将训练完成的场景发布为服务,发布服务后即可对接环境完成决策管理。决策管理可以展示为柱状图(见图3)或折线面积图(见图4)。进行强化学习平台和仿真系统之间的数据对接,将仿真系统中的实时态势转化成智能体的观测,并将智能体的决策转化成仿真系统的指令。根据仿真环境选择适用的算法,自动生成神经网络模型[15]。根据智能体训练的需要,进行规则设定,将设定好的规则在强化学习适配器中进行编程实现,并融入到强化学习平台智能体训练中。在仿真系统中进行红、蓝智能体的对抗模拟,环境的状态为红蓝双方所共同感知,智能体根据环境状态为红蓝双方决策动作,在模型训练时设定蓝方策略,并根据蓝方策略实现红方智能体模型的训练。依据多次试错所获得的瞬时奖励值选择行为策略,同时考虑环境的不确定性和目标的长远性,当红方智能体训练过程中所输出的奖励曲线呈现收敛趋势后,固定红方智能体,训练蓝方智能体并调整训练的轮数,使蓝方智能体的奖励曲线呈现收敛趋势。收敛趋势的定义为:每N次模型更新为一个阶段,对每个阶段计算训练开始至今的最大奖励,计算每个阶段与前一个阶段的最大奖励增幅,如果某阶段结束后,最大奖励增幅相较前一个增幅不提升,则认为出现收敛趋势[16],增大N的取值会增大出现收敛趋势的理论最短时间。

图4 决策管理折线面积图

Fig.4 Decision management line area chart

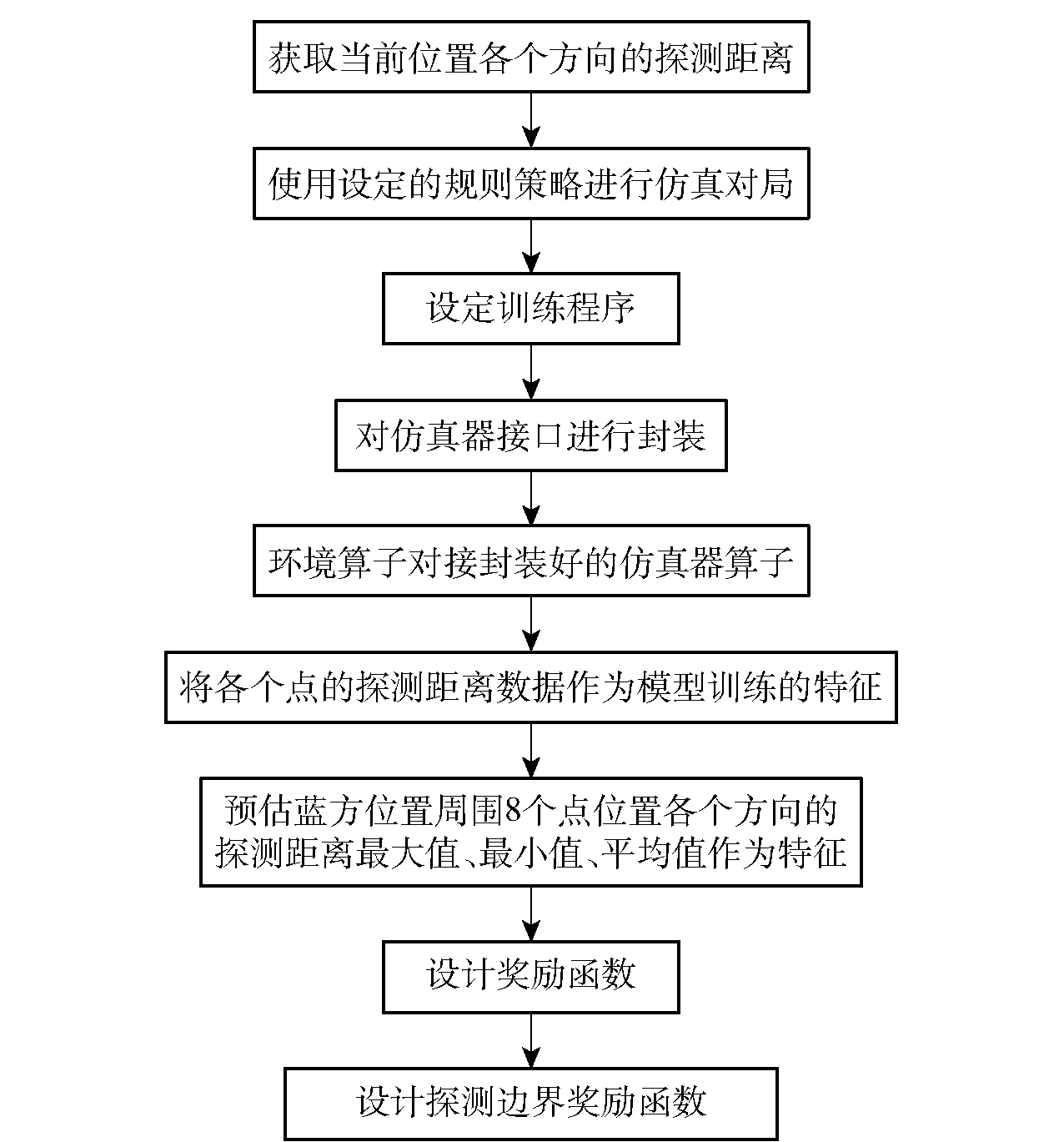

智能无人系统经常用于执行探测任务,下面以探测决策为例进行描述(见图5):

图5 基于强化学习进行探测决策

Fig.5 Decision-making detection based on

reinforcement learning

根据所在位置的经纬度获取当前位置各个方向的探测距离。在仿真平台使用设定的规则策略进行仿真对局。在强化学习平台配合仿真平台设定训练程序,如果获取到的是重复的状态信息,则不执行动作,直至获取到不同的状态信息。由于仿真平台更新状态信息时间并不固定,训练程序间隔固定时间获取到的状态无法确定是否为更新后的,因此获取状态信息等待方式以状态是否更改为标准。使用自定义仿真器,对仿真器接口进行封装,使其在强化学习平台上以一个算子的形式进行对接。使用自定义环境算子对接封装好的仿真器算子,在算子中调用仿真器的接口进行信息交互。在强化学习训练算子中启用自定义模型来控制智能体的动作。将各个点的探测距离数据作为模型训练的特征,进行模型训练。在红方发现蓝方后,预估蓝方位置周围8个点位置各个方向的探测距离最大值、最小值、平均值作为特征。强化学习通过与环境交互习得任务的决策策略,具有自学习和在线学习的特点,在需要感知高维度输入数据和决策管理的探测任务中应用强化学习时,这种交互试错机制会导致算法的运行效率太低,收敛速度比较慢,由于没有明确的监督信号,强化学习的学习速度会很慢,此时智能无人系统需要在与环境交互时依靠奖励信号来调整动作。在强化学习平台设计奖励函数,计算当前实际距离和预估的探测距离,根据距离进行相关的奖励和惩罚。设计边界奖励函数,如果在边界范围(边界范围包括探测深度)内,即使距离边界很近,只要不出边界就不进行惩罚,出了边界,距离越远惩罚越大,按照指数递增的方式加大惩罚值。

强化学习是智能无人系统实现对复杂及不确定环境具备良好适应性的有效手段,也是智能无人系统决策管理的核心技术之一。由于智能无人系统经常用于执行探测任务,以探测决策为例对强化学习辅助决策的过程进行了描述,应用强化学习后探测决策的智能化程度大幅提高。综上所述,强化学习的实质是智能无人系统从环境到动作映射的学习,以使奖励函数值最大。强化学习算法通过与所处环境不断进行自主交互来得到策略,将强化学习的决策能力与智能无人系统的感知能力相结合,通过端对端的学习方式,能够实现从输入到输出的直接控制。但是强化学习的这种特性必然会使智能无人系统的学习时间增长,如何提高强化学习的速度是一个重要问题。未来,智能无人系统依赖强大的决策支持,强化学习技术将在智能无人系统决策管理中发挥不可替代的作用。

[1] 严浙平,杨泽文,王璐,等.马尔科夫理论在无人系统中的研究现状[J].中国舰船研究,2018,13(6):9-18.

YAN Z P,YANG Z W,WANG L,et al. Research status of Markov theory in unmanned systems[J]. Chinese Journal of Ship Research,2018,13(6):9-18. (in Chinese)

[2] 张涛,李清,张长水,等.智能无人自主系统的发展趋势[J].无人系统技术,2018(1):11-22.

ZHANG T,LI Q,ZHANG C S,et al. Current trends in the development of intelligent unmanned autonomous systems[J]. Unmanned Systems Technology, 2018(1):11-22. (in Chinese)

[3] 宋庆庆,卫浩,李健,等.美军自主无人系统关键技术现状及发展趋势[J].装备制造技术,2018(11):126-128.

SONG Q Q,WEI H,LI J, et al.Current situation and development trend of key technologies of US army autonomous unmanned systems[J].Equipment Manufacturing Technology,2018(11):126-128. (in Chinese)

[4] 刘乐华,赵蛟龙,巩天成.美国水下无人系统发展趋势分析[J].数字海洋与水下攻防,2019,2(1):18-23.

LIU L H,ZHAO J L,GONG T C.Analysis on development trend of US unmanned undersea systems[J].Digital Ocean & Undewater Warfare,2019,2(1):18-23.(in Chinese)

[5] 薛春祥,黄孝鹏,朱咸军,等.外军无人系统现状与发展趋势[J].雷达与对抗,2016,36(1):1-5.

XUE C X,HUANG X P,ZHU X J, et al.Status quo and development trends of foreign military’s unmanned systems[J].Radar & ECM,2016,36(1):1-5. (in Chinese)

[6] 王圣洁,康凤举,韩翃.潜艇与智能无人水下航行器协同系统控制体系及决策研究[J].兵工学报,2017,38(2):335-344.

WANG S J,KANG F J,HAN H.Research on control and decision-making of submarine and intelligent UUV cooperative system[J]. Acta Armamentarii,2017,38(2):335-344. (in Chinese)

[7] 潘光,宋保维,黄桥高,等.水下无人系统发展现状及其关键技术[J].水下无人系统学报,2017,25(1):44-51.

PAN G,SONG B W,HUANG Q G, et al.Development and key techniques of unmanned undersea system[J].Journal of Unmanned Undersea Systems, 2017,25(1):44-51.(in Chinese)

[8] 赵欣怡,宗群,张睿隆,等.类脑智能技术在无人系统上的应用[J].控制理论与应用,2019,36(1):1-12.

ZHAO X Y,ZONG Q,ZHANG R L, et al.Application of brain-inspired intelligence technology inunmanned vehicles[J].Control Theory & Applications, 2019,36(1):1-12. (in Chinese)

[9] 冷鹏飞,徐朝阳.一种深度强化学习的雷达辐射源个体识别方法[J].兵工学报,2018,39(12):2420-2426.

LENG P F,XU C Y.Specific emitter identification based on deep reinforcement learning[J].Acta Armamentarii,2018,39(12):2420-2426. (in Chinese)

[10] 刘全,翟建伟,章宗长,等.深度强化学习综述[J].计算机学报,2018,41(1):1-27.

LIU Q,ZHAI J W,ZHANG Z Z, et al.A Survey on deep reinforcement learning[J].Chinese Journal of Computers,2018,41(1):1-27. (in Chinese)

[11] 周文吉,俞扬.分层强化学习综述[J].智能系统学报,2017,12(5):590-594.

ZHOU W J,YU Y.Summarize of hierarchical reinforcement learning[J].CAAI Transactions on Intelligent Systems, 2017,12(5):590-594. (in Chinese)

[12] 刘志荣,姜树海.基于强化学习的移动机器人路径规划研究综述[J].制造业自动化,2019(3):90-92.

LIU Z R,JIANG S H.Review of mobile robot path planning based on reinforcement learning[J].Manufacturing Automation, 2019(3):90-92.(in Chinese)

[13] 万里鹏,兰旭光,张翰博,等.深度强化学习理论及其应用综述[J].模式识别与人工智能,2019(1):67-81.

WAN L P,LAN X G,ZHANG H B, et al.A Review of deep reinforcement learning theory and application[J].Pattern Recognition and Artificial Intelligence, 2019(1):67-81. (in Chinese)

[14] 马骋乾,谢伟,孙伟杰.强化学习研究综述[J].指挥控制与仿真,2018(6):68-72.

MA C Q,XIE W,SUN W J.Research on reinforcement learning technology:a review[J].Command Control & Simulation, 2018(6):68-72. (in Chinese)

[15] GOODLELLOW I,BENGIO Y, COURILLE A.Deep learning[M].Cambrige,MA,US:MIT Press,2016.

[16] SUTTON R,BARTO A.Reinforcement learning:an introduction[M].Cambrige,MA,US:MIT Press,2017.

© 2019-2021 All rights reserved. 北京转创国际管理咨询有限公司 京ICP备19055770号-1

Beijing TransVenture International Management Consulting Co., Ltd.

地址:佛山市金融高新区京华广场

北京市大兴区新源大街25号院恒大未来城7号楼1102室

西安市经济技术开发区凤城五路豪佳花园3幢42108室

深圳市南山区高新科技园南区R2-B栋4楼12室

梅州市丰顺县留隍镇新兴路881号

欢迎来到本网站,请问有什么可以帮您?

稍后再说 现在咨询